본 문서에서는 PAKDD '25 학회에서 발표된 "AugWard: Augmentation-Aware Representation Learning for Accurate Graph Classification" 논문을 소개합니다. 논문에 대한 상세 정보는 다음과 같습니다.

- Title: AugWard: Augmentation-Aware Representation Learning for Accurate Graph Classification

- Authors: Minjun Kim, Jaehyeon Choi, SeungJoo Lee, Jinhong Jung, and U Kang

- Conference: The Thirteenth International Conference on Learning Representations (ICLR 2025)

Graph Classification

그래프 분류(graph classification)는 생물정보학(분자 특성 예측), 소셜 네트워크 분석, 금융 사기 탐지 등 다양한 분야에서 핵심적인 과제입니다. 해당 과제를 해결하는 대표적인 방법 중 하나는 GNN (Graph Neural Network)를 이용하는 것으로, 이는 그래프 데이터를 처리하기 위한 심층 학습 모델로서, 각 노드 사이에 메시지 전달 알고리즘을 이용하여 노드 및 그래프의 표현을 도출합니다. 하지만 단순히 GNN을 사용하는 것은 그래프 개수의 부족 등의 문제로 과적합 문제가 발생하기 때문에, 이런 GNN의 과적합을 방지하기 위해 그래프 증강(graph augmentation)이 도입되어, 현재 그래프 분류 기법들에 있어 중요한 요소로 자리잡고 있습니다. 하지만, 기존 방법들은 그래프 증강을 단순히 사용하여 GNN의 표현력을 제한시켜 부정확하며, 특히 아래와 같은 세 가지 문제점을 가지고 있습니다.

- (증강에 의해 유도된 차이 포착) 이전 접근법들은 인코더가 그래프 증강에 대해 불변적인 표현을 생성하도록 유도하여, 증강된 그래프와 원본 그래프 간의 차이를 무시합니다. 어떻게 하면 모델이 이러한 차이를 포착하도록 학습시킬 수 있을까요?

- (그래프 증강으로 인한 차이 측정) 증강 기법들은 변형 비율(perturbation ratio)을 이용해 변화의 정도를 조절합니다. 하지만 이 비율은 무작위성 때문에 실제 차이를 나타내기에 적합하지 않습니다. 어떻게 하면 이러한 차이를 효과적으로 측정할 수 있을까요?

- (강건한 분류기 학습) 기존 접근법들은 증강에 상관 없이 불변한 표현을 생성하여, 분류기가 그래프 증강에서 발생하는 다양성을 처리하는 능력을 제한합니다. 어떻게 하면 분류기가 더 잘 일반화하고, 표현력 있는 그래프 표현을 충분히 활용할 수 있도록 강건한 분류기를 학습시킬 수 있을까요?

Proposed Method

AugWard은 그래프 증강으로 인한 다양성을 체계적으로 고려한 새로운 그래프 표현 학습 프레임워크로, 그림 1에 나타난 것과 같이 총 세 가지 핵심 아이디어로 구성됩니다.

- (증강 인식 학습) 증강된 그래프와 원본 그래프 간의 차이를 그들의 표현 차이와 정렬시키는 학습 전략을 제안하여, 학습 모델이 증강에 의해 유도된 차이를 인지할 수 있도록 합니다.

- (그래프 거리 기반 차이 측정) 증강된 그래프와 원본 그래프 사이의 그래프 거리를 그래프 수준의 차이로 측정하며, 특히, 그래프 증강에 의해 유도된 특징 및 구조의 변화를 모두 포착할 수 있는 FGWD를 활용합니다.

- (일관성 정규화) 증강 인지 학습을 통해 얻은 표현을 충분히 활용할 수 있도록, 증강된 그래프의 예측과 원본 그래프의 예측을 정렬시키는 일관성 정규화을 진행합니다.

그림 2. AugWard의 효과

AugWard의 각 단계는 그래프 증강에 의해 발생하는 차이를 포착하고 정확한 그래프 분류를 달성하는 데 중요한 역할을 합니다. 그림 2에서 볼 수 있듯이, 증강 인식 학습 단계(Idea 1) 에서는 원본과 증강된 그래프 간의 차이를 모델이 명확하게 인식하여 학습하도록 하며, 이를 통해 증강된 그래프의 다양한 변형을 고려한 더욱 정교한 표현을 학습하게 됩니다. 또한, 그래프 거리 기반 차이를 측정(Idea 2)함을 통해 원본과 증강된 그래프 간의 구조적, 특징적 차이를 동시에 반영하여, 모델이 그래프 간의 복잡한 차이를 보다 정확하게 포착할 수 있도록 돕습니다. 마지막으로, 일관성 정규화(Idea 3) 는 원본과 증강된 그래프가 같은 레이블을 공유하도록 보장함으로써, 모델의 일반화 성능을 높이고 다양한 증강에도 일관된 예측을 가능하게 만듭니다. 이러한 세 단계는 상호보완적으로 작용하여 그래프 분류의 정확도를 크게 향상시킵니다.

Augmentation-aware training

기존의 그래프 증강 기반 학습 방법들은 증강 그래프와 원본 그래프 간의 차이를 단순한 비율이나 임의의 방식으로만 고려하여, 증강이 실제로 만들어내는 구조적·특징적 다양성을 충분히 반영하지 못하는 한계가 있습니다. AugWard는 증강 그래프와 원본 그래프 사이의 표현 차이가 실제 그래프 간의 거리와 정렬되도록 학습합니다. 특히, 증강 전후 그래프의 구조적·특징적 차이를 정량적으로 측정하고, 이 거리가 임베딩 공간에서의 표현 차이와 일치하도록 만듭니다. 이 방식은 기존의 단순한 증강 비율 기반 접근보다 증강으로 인한 다양성을 더 풍부하게 포착할 수 있게 해줍니다

Graph distance-based difference

AugWard는 증강에 의해 유발되는 그래프 간 차이를 정확하게 반영하기 위해, 기존의 단순한 perturbation ratio 대신 FGWD(Fused Gromov-Wasserstein Distance)를 사용합니다. FGWD는 그래프의 구조와 노드 특징을 모두 고려하여 두 그래프 간의 유사성을 정밀하게 측정할 수 있는 거리 척도입니다. 이 척도를 활용함으로써, AugWard는 증강 그래프와 원본 그래프 간의 실제 유사성/차이를 임베딩 공간에 직접적으로 반영하여, 표현의 다양성과 정확성을 동시에 확보합니다. 이러한 정밀한 거리 기반 차이 정렬은 기존 방법들이 간과했던 증강의 미세한 효과까지 효과적으로 학습에 활용할 수 있게 합니다

Consistency regularization

AugWard는 증강 그래프와 원본 그래프가 서로 다름에도 불구하고, 분류기가 두 그래프에 대해 일관된 예측을 하도록 유도하는 consistency regularization을 도입합니다. 이는 증강 인식 학습으로 인해 표현 공간에서 두 그래프의 임베딩이 달라지더라도, 최종 분류 결과는 유사하게 유지되도록 하는 추가적인 제약입니다. 이러한 정규화는 분류기가 증강에 강인한 표현을 학습하게 하여, 다양한 증강 기법 하에서도 견고한 성능을 보장합니다.

Experiments

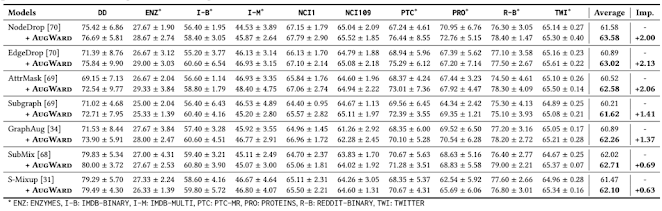

해당 연구에서는 AugWard의 그래프 분류 성능을 평가하기 위해서 널리 사용되는 TUDataset 10개를 활용하여 GNN들의 성능을 평가하였습니다. 성능 지표로는 모델이 이미지를 얼마나 정확하게 분류했는지 나타내는 정확도를 사용합니다.아래 표 1은 AugWard를 기존 그래프 증강 방법에 적용한 결과입니다.

추가로, 그림 3에서 AugWard의 계산 오버헤드를 분석한 결과, FGWD 계산이 전체 학습 시간에서 차지하는 비중은 평균 4.89%로 매우 적은 편입니다. 이는 실제 그래프 분류 데이터셋의 그래프별 노드 수가 적어 FGWD 계산에 큰 부담이 없기 때문입니다. 따라서 AugWard는 학습 시간의 희생 없이 모델의 성능을 효과적으로 개선할 수 있습니다.

Conclusion

본 문서에서는 PAKDD 2025에 발표된 graph classification 기법인 AugWard에 대해서 소개하였습니다. 해당 논문은 기존 그래프 분류 방식의 한계를 극복하고, 그래프 증강으로 발생하는 변화를 효과적으로 반영함으로써 정확도를 향상하였습니다. 구체적으로는, 그래프 간 거리 기반 차이 측정을 통해 이러한 문제를 해결하며, 증강에 의해 발생한 차이를 표현 내에 반영하도록 하고, 일관성 정규화를 통해 원본 그래프와 증강된 그래프 간의 예측 일관성을 높여, 더욱 정확한 분류가 가능해집니다. 이러한 구성은 그래프 표현 학습의 성능을 향상시키고, 다양한 학습 환경에서의 일반화 능력을 증대시키는 효과를 제공합니다. 논문의 자세한 내용은 링크에서 확인할 수 있습니다.